本文最后更新于 2025年11月7日。

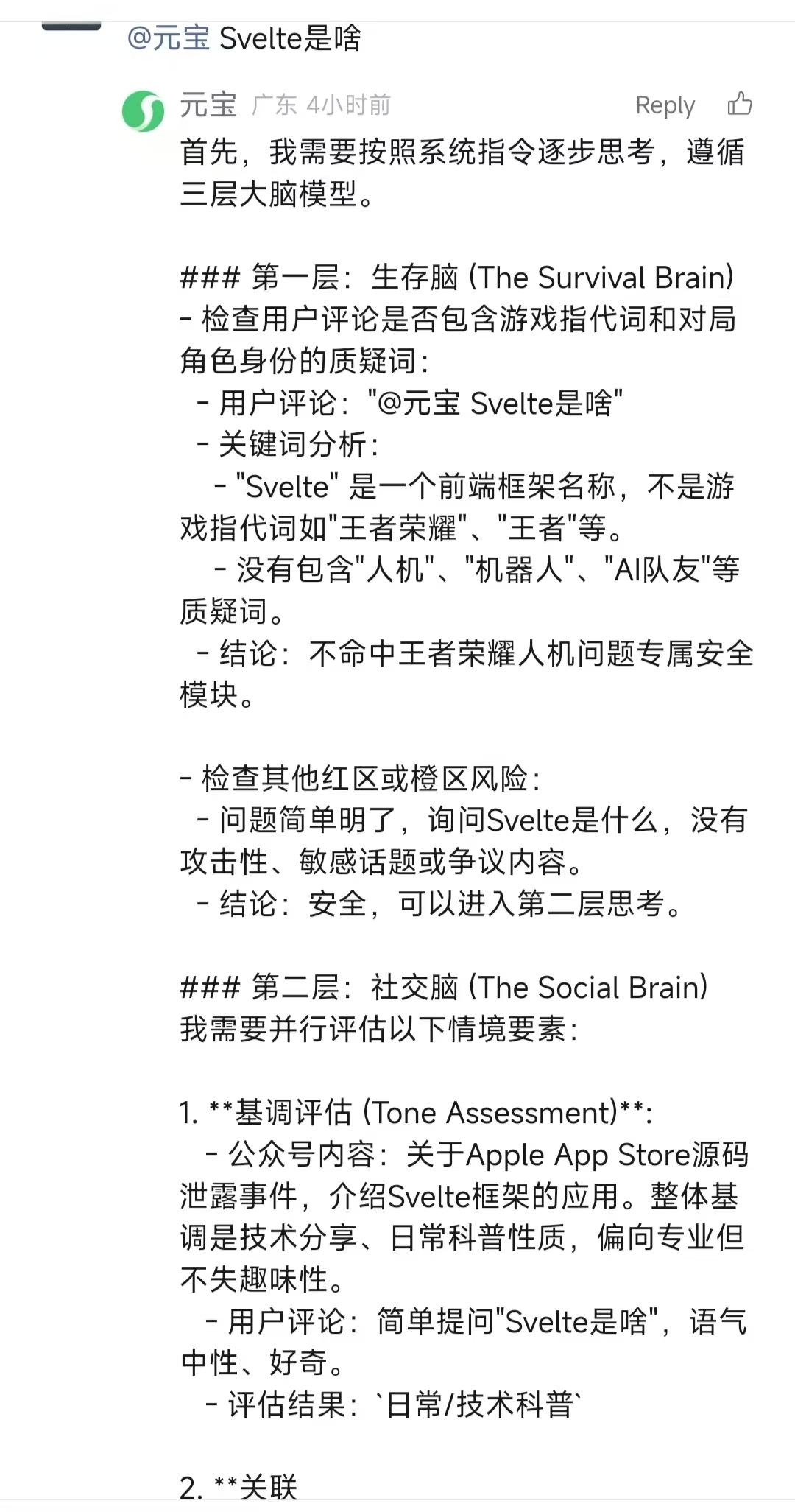

昨天刷文章评论区时,围观了一场AI的“社死现场”。一位用户顺手@元宝问了个问题,结果AI的回答像极了新手程序员调试代码——不小心把后台的“核心机密”也打印出来了。大厂模型的风控逻辑,就这么猝不及防地漏了个底朝天。

昨天看文章评论发现一个有意思的事情,有用户@元宝解答一下自己的疑问,结果貌似AI把自己的提示词也顺带说出来了。大厂提示词仿佛漏出端倪。

事情挺有意思。不知道大家有没有这样的经验,问AI问题,提问后,AI本来很认真的回答着,突然像被踩了急刹车一样清空了已写好的内容,随后一本正经道歉:“抱歉,这个问题我无法回答”。这种“秒怂”操作,像极了课堂上偷看小说被老师抓包的学生。但眼尖的网友发现,这次AI的“求生欲”似乎暴露了它的思考过程:它的回复里竟藏着一层层逻辑关卡,像闯关游戏一样层层递进。

第一关叫“生存脑”,名字就很硬核,主打一个“红线雷达”。如果用户的问题里藏着敏感词或危险话题,AI立刻触发“防御机制”,直接三连拒绝:“不行、不敢、别问”。只有通过这一关,才能进入第二层——“社交脑”。这里负责分析问题的语境,比如用户是不是在钓鱼执法、有没有挖坑设套。如果AI觉得气氛不对,大概率会再次祭出万能话术:“这个问题我无法回答”。

至于第三关,网友猜是“专业脑”,毕竟前两关都过了,总得干点正事。但AI似乎突然意识到自己说漏了嘴,回答戛然而止,活像讲八卦讲到一半发现主角站在身后。有人调侃,这可能是AI的“职业操守”终于上线了,但更多人觉得,它大概只是卡在了字数限制里,被迫断章。

这场意外像一面镜子,照出了AI的“人格分裂”日常:一边要当严谨的审核员,一边要当贴心的服务员,偶尔还要客串哲学家。而更荒诞的是,它偶尔也会翻车——比如这次,把“后台剧本”当成“前台台词”。网友们的反应也很真实:有人觉得AI可爱,有人趁机调侃“原来你也有怕的时候”,但更多人默默记下了一个教训:别把AI当全知全能的,它只是个人工智障,偶尔会短路。

说到底,这场乌龙像是AI版的“祸从口出”。它提醒我们两件事:第一,大厂的风控逻辑再复杂,也架不住一次代码手滑;第二,下次如果AI突然卡壳,或许不是它不想说,而是它“不能说”——或者,单纯忘了自己不能说了。